| 澶辨晥閾炬帴澶勭悊 |

|

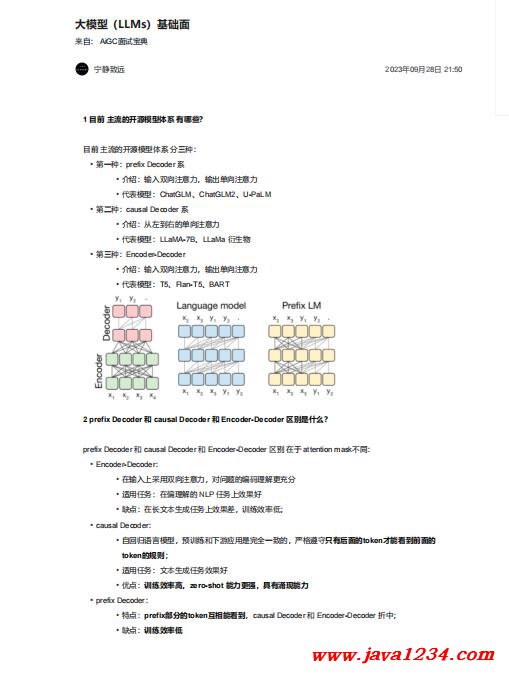

澶фā鍨嬶紙LLMs錛夊熀紜€闈㈣瘯棰?nbsp; PDF 涓嬭澆

鐩稿叧鎴浘錛?/strong>

涓昏鍐呭錛?/strong>

4娑岀幇鑳藉姏鏄暐鍘熷洜? 鏍規(guī)嵁鍓嶄漢鍒嗘瀽鍜岃鏂囨€葷粨錛屽ぇ鑷存槸2涓寽鎯?·浠誨姟鐨勮瘎浠鋒寚鏍囦笉澶熷鉤婊? ·澶嶆潅浠誨姟vs瀛愪換鍔★紝榪欎釜鍏跺疄濂界悊瑙o紝姣斿鎴戜滑鍋囪鏌愪釜浠誨姟T鏈?涓瓙浠誨姟Sub-T鏋勬垚錛屾瘡涓猻ub-T闅忕潃妯″瀷澧為暱錛屾寚鏍囦粠40%鎻愬崌鍒?0%錛屼絾鏄渶緇堜換鍔$殑鎸囨爣鍙粠1.1%鎻愬崌鍒頒簡7%錛屼篃灝辨槸璇村畯瑙備笂鐪嬪埌浜嗘秾鐜扮幇璞★紝浣嗘槸浜嗕換鍔℃晥鏋滃叾瀹炴槸騫蟲粦澧為暱鐨勩€?/span>

5涓轟綍鐜板湪鐨勫ぇ妯″瀷澶ч儴鍒嗘槸Decoder only緇撴瀯? 鍥犱負decoder-only緇撴瀯妯″瀷鍦ㄦ病鏈変換浣曞井璋冩暟鎹殑鎯呭喌涓嬶紝zeroshot鐨勮〃鐜拌兘鍔涙渶濂姐€傝€宔ncoder-decoder鍒欓渶瑕佸湪涓€瀹氶噺鐨勬爣娉ㄦ暟鎹笂鍋歮ultitask-finetuning鎵嶈兘澶熸縺鍙戞渶浣蟲€ц兘銆?/span> 鐩墠鐨凩arge LM鐨勮緇冭寖寮忚繕鏄湪澶ц妯¤鏂檚hang鍋氳嚜鐩戠潱瀛︿範錛屽緢鏄劇劧zero-hot鎬ц兘鏇村ソ鐨刣ecoder-only鏋舵瀯鎵嶈兘鏇村ソ鐨勫埄鐢ㄨ繖浜涙棤鏍囦富鐨勬暟鎹€?/span> 澶фā鍨嬩嬌鐢╠ecoder-only鏋舵瀯闄や簡璁粌鏁堢巼鍜屽伐紼嬪疄鐜頒笂鐨勪紭鍔垮錛屽湪鐞嗚涓婂洜涓篍ncoder鐨勫弻鍚戞敞鎰忓姏浼氬瓨鍦ㄤ綆縐╃殑闂錛岃繖鍙兘浼氬墛寮辨ā鍨嬬殑琛ㄨ揪鑳藉姏銆傚氨鐢熸垚浠誨姟鑰岃█錛屽紩鍏ュ弻鍚戞敞鎰忓姏騫舵棤瀹炶川鐨勫ソ澶勩€傝€孍ncoder-decoder妯″瀷鏋舵瀯涔嬫墍浠ヨ兘澶熷湪鏌愪簺鍦烘櫙涓嬭〃鐜版洿濂斤紝澶ф鏄洜涓哄畠澶氫簡涓€鍊嶅弬鏁般€傛墍浠ュ湪鍚岀瓑鍙傛暟閲忋€佸悓絳夋帹鐞嗘垚鏈笅錛孌ecoder-only鏋舵瀯灝辨槸鏈€浼樼殑閫夋嫨浜嗐€?/span>

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>