| 澶辨晥閾炬帴澶勭悊 |

|

鎻愮ず瀛︿範(fàn)錛圥rompting錛夌瘒 PDF 涓嬭澆

杞澆鑷細(xì)http://www.python222.com/article/1195

鐩稿叧鎴浘錛?/strong>

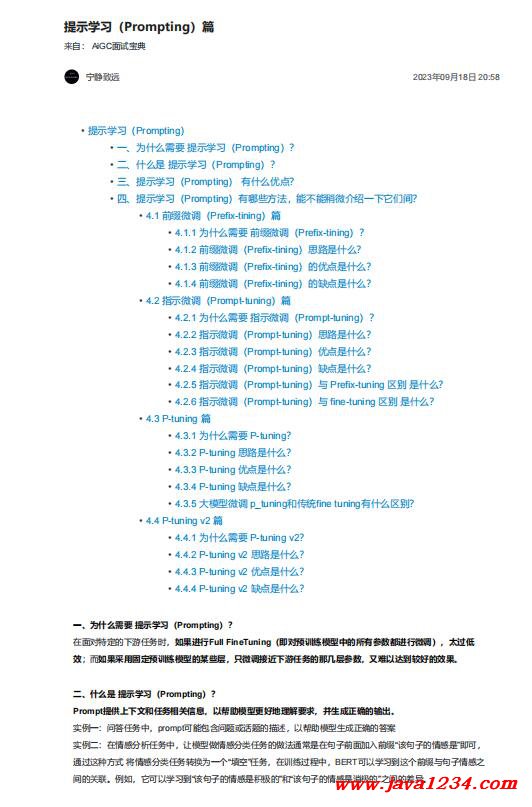

涓昏鍐呭錛?/strong> 涓€銆佷負(fù)浠€涔堥渶瑕?鎻愮ず瀛︿範(fàn)錛?/strong>Prompting錛夛紵

鍦ㄩ潰瀵圭壒瀹氱殑涓嬫父浠誨姟鏃訛紝濡傛灉榪涜Full FineTuning錛堝嵆瀵歸璁粌妯″瀷涓殑鎵€鏈夊弬鏁伴兘榪涜寰皟錛夛紝澶繃浣?/strong>

鏁?/strong>錛涜€?/span>濡傛灉閲囩敤鍥哄畾棰勮緇冩ā鍨嬬殑鏌愪簺灞傦紝鍙井璋冩帴榪戜笅娓鎬換鍔$殑閭e嚑灞傚弬鏁幫紝鍙堥毦浠ヨ揪鍒拌緝濂界殑鏁堟灉銆?/span>

浜屻€佷粈涔堟槸 鎻愮ず瀛︿範(fàn)錛?/strong>Prompting錛夛紵

Prompt鎻愪緵涓婁笅鏂囧拰浠誨姟鐩稿叧淇℃伅錛屼互甯姪妯″瀷鏇村ソ鍦扮悊瑙h姹傦紝騫剁敓鎴愭紜殑杈撳嚭銆?/span>

瀹炰緥涓€錛氶棶絳斾換鍔′腑錛?/span>prompt鍙兘鍖呭惈闂鎴栬瘽棰樼殑鎻忚堪錛屼互甯姪妯″瀷鐢熸垚姝g‘鐨勭瓟妗?/span>

瀹炰緥浜岋細(xì)鍦ㄦ儏鎰熷垎鏋愪換鍔′腑錛岃妯″瀷鍋氭儏鎰熷垎綾諱換鍔$殑鍋氭硶閫氬父鏄湪鍙ュ瓙鍓嶉潰鍔犲叆鍓嶇紑“璇ュ彞瀛愮殑鎯呮劅鏄?/span>”鍗沖彲錛?/span>

閫氳繃榪欑鏂瑰紡 灝嗘儏鎰熷垎綾諱換鍔¤漿鎹負(fù)涓€涓?/span>“濉┖”浠誨姟錛屽湪璁粌榪囩▼涓紝BERT鍙互瀛︿範(fàn)鍒拌繖涓墠緙€涓庡彞瀛愭儏鎰熶箣

闂寸殑鍏寵仈銆備緥濡傦紝瀹冨彲浠ュ涔?fàn)鍒?/span>“璇ュ彞瀛愮殑鎯呮劅鏄Н鏋佺殑”鍜?/span>“璇ュ彞瀛愮殑鎯呮劅鏄秷鏋佺殑”涔嬮棿鐨勫樊寮傘€?/span>

涓夈€佹彁紺哄涔?fàn)锛?/strong>Prompting錛?鏈変粈涔堜紭鐐癸紵

鎻愮ず瀛︿範(fàn)錛?/span>Prompting錛夋棬鍦?/span>閫氳繃鏈€灝忓寲寰皟鍙傛暟鐨勬暟閲忓拰璁$畻澶嶆潅搴︼紝鏉ユ彁楂橀璁粌妯″瀷鍦ㄦ柊浠誨姟涓婄殑鎬ц兘錛?/strong>

浠庤€岀紦瑙eぇ鍨嬮璁粌妯″瀷鐨勮緇冩垚鏈?/strong>銆傝繖鏍蜂竴鏉ワ紝鍗充嬌璁$畻璧勬簮鍙楅檺錛屼篃鍙互鍒╃敤棰勮緇冩ā鍨嬬殑鐭ヨ瘑鏉ヨ繀閫熼€傚簲

鏂頒換鍔★紝瀹炵幇楂樻晥鐨勮縼縐誨涔?fàn)銆?/span>

鍥涖€佹彁紺哄涔?fàn)锛?/strong>Prompting錛夋湁鍝簺鏂規(guī)硶錛岃兘涓嶈兘紼嶅井浠嬬粛涓€涓嬪畠浠棿錛?/strong>

4.1 鍓嶇紑寰皟錛?/strong>Prefix-tining錛夌瘒

4.1.1 涓轟粈涔堥渶瑕?鍓嶇紑寰皟錛?/strong>Prefix-tining錛夛紵

1. 浜哄伐璁捐紱繪暎鐨?/span> Prompts 緙虹偣錛?/span>

a. Prompts 鐨勫彉鍖栧妯″瀷鏈€緇堢殑鎬ц兘鐗瑰埆鏁忔劅錛屽姞涓€涓瘝銆佸皯涓€涓瘝鎴栬€呭彉鍔ㄤ綅緗兘浼?xì)閫犳垚姣旇緝澶х殑

鍙樺寲

2. 鑷姩鍖栨悳绱㈢鏁g殑 Prompts 緙虹偣錛?/span>

a. 鎴愭湰涔熸瘮杈冮珮

3. 紱繪暎鍖栫殑token鎼滅儲鍑烘潵鐨勭粨鏋滃彲鑳藉茍涓嶆槸鏈€浼樼殑錛?/span>

4. 浼犵粺鐨勫井璋冭寖寮忓埄鐢ㄩ璁粌妯″瀷鍘誨涓嶅悓鐨勪笅娓鎬換鍔¤繘琛屽井璋冿紝瀵規(guī)瘡涓換鍔¢兘瑕佷繚瀛樹竴浠藉井璋冨悗鐨勬ā鍨嬫潈

閲?/strong>錛屼竴鏂歸潰寰皟鏁翠釜妯″瀷鑰楁椂闀匡紱鍙︿竴鏂歸潰涔熶細(xì)鍗犲緢澶氬瓨鍌ㄧ┖闂?/span>

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>