| 澶辨晥閾炬帴澶勭悊 |

|

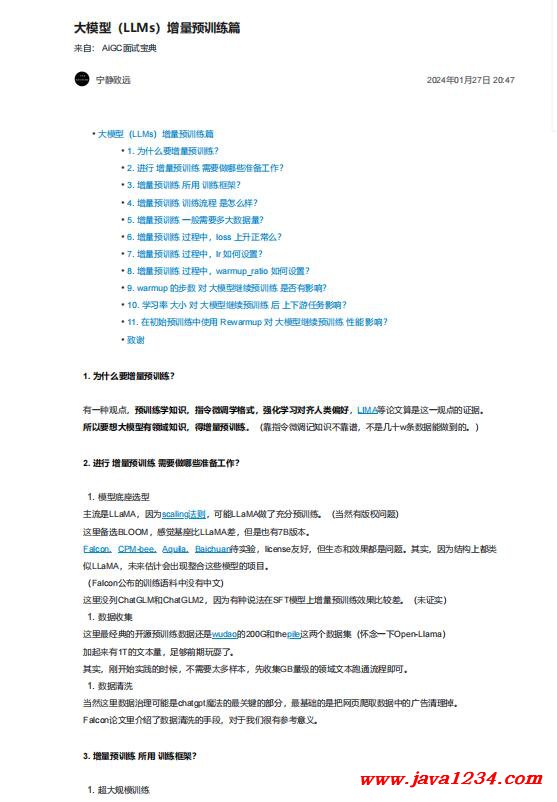

澶фā鍨嬶紙LLMs錛夊閲忛璁粌綃?nbsp; PDF 涓嬭澆

鐩稿叧鎴浘錛?/strong>

涓昏鍐呭錛?/strong>

1. 涓轟粈涔堣澧為噺棰勮緇冿紵

鏈変竴縐嶈鐐癸紝棰勮緇冨鐭ヨ瘑錛屾寚浠ゅ井璋冨鏍煎紡錛屽己鍖栧涔犲榻愪漢綾誨亸濂?/strong>錛?/span>LIMA絳夎鏂囩畻鏄繖涓€瑙傜偣鐨勮瘉鎹€?/span>

鎵€浠ヨ鎯沖ぇ妯″瀷鏈夐鍩熺煡璇嗭紝寰楀閲忛璁粌銆傦紙闈犳寚浠ゅ井璋冭鐭ヨ瘑涓嶉潬璋憋紝涓嶆槸鍑犲崄w鏉℃暟鎹兘鍋氬埌鐨勩€傦級

2. 榪涜 澧為噺棰勮緇?闇€瑕佸仛鍝簺鍑嗗宸ヤ綔錛?/strong>

1. 妯″瀷搴曞駭閫夊瀷

涓繪祦鏄?/span>LLaMA錛屽洜涓?/span>scaling娉曞垯錛屽彲鑳?/span>LLaMA鍋氫簡鍏呭垎棰勮緇冦€傦紙褰撶劧鏈夌増鏉冮棶棰橈級

榪欓噷澶囬€?/span>BLOOM錛屾劅瑙夊熀搴ф瘮LLaMA宸紝浣嗘槸涔熸湁7B鐗堟湰銆?/span>

Falcon銆?/span>CPM-bee銆?/span>Aquila銆?/span>Baichuan寰呭疄楠岋紝license鍙嬪ソ錛屼絾鐢熸€佸拰鏁堟灉閮芥槸闂銆傚叾瀹烇紝鍥犱負緇撴瀯涓婇兘綾?/span>

浼?/span>LLaMA錛屾湭鏉ヤ及璁′細鍑虹幇鏁村悎榪欎簺妯″瀷鐨勯」鐩€?/span>

錛?/span>Falcon鍏竷鐨勮緇冭鏂欎腑娌℃湁涓枃錛?/span>

榪欓噷娌″垪ChatGLM鍜?/span>ChatGLM2錛屽洜涓烘湁縐嶈娉曞湪SFT妯″瀷涓婂閲忛璁粌鏁堟灉姣旇緝宸€傦紙鏈瘉瀹烇級

榪欓噷鏈€緇忓吀鐨勫紑婧愰璁粌鏁版嵁榪樻槸wudao鐨?/span>200G鍜?/span>thepile榪欎袱涓暟鎹泦錛堟€€蹇典竴涓?/span>Open-Llama錛?/span>

鍔犺搗鏉ユ湁1T鐨勬枃鏈噺錛岃凍澶熷墠鏈熺帺鑰嶄簡銆?/span>

鍏跺疄錛屽垰寮€濮嬪疄璺電殑鏃跺€欙紝涓嶉渶瑕佸お澶氭牱鏈紝鍏堟敹闆?/span>GB閲忕駭鐨勯鍩熸枃鏈窇閫氭祦紼嬪嵆鍙€?/span>

褰撶劧榪欓噷鏁版嵁娌葷悊鍙兘鏄?/span>chatgpt欖旀硶鐨勬渶鍏抽敭鐨勯儴鍒嗭紝鏈€鍩虹鐨勬槸鎶婄綉欏電埇鍙栨暟鎹腑鐨勫箍鍛婃竻鐞嗘帀銆?/span>

Falcon璁烘枃閲屼粙緇嶄簡鏁版嵁娓呮礂鐨勬墜孌碉紝瀵逛簬鎴戜滑寰堟湁鍙傝€冩剰涔夈€?/span>

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>