| 澶辨晥閾炬帴澶勭悊 |

|

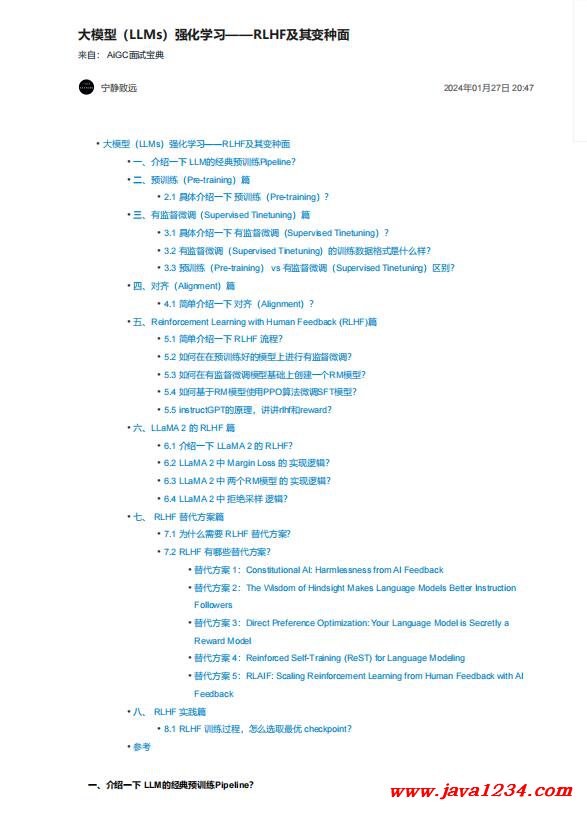

澶фā鍨嬶紙LLMs錛夊己鍖栧涔?mdash;—RLHF鍙婂叾鍙樼闈?nbsp; PDF 涓嬭澆

鐩稿叧鎴浘錛?/strong>

涓昏鍐呭錛?/strong> 涓€銆佷粙緇嶄竴涓?/strong> LLM鐨勭粡鍏擱璁粌Pipeline錛?/strong>

鐩墠鍩轟簬Transformer decoder鐨?/span>LLM錛屾瘮濡?/span>ChatGPT銆?/span>LLaMA銆?/span>baichuan絳夛紝閫氬父閮戒細鏈夊熀浜庨璁粌鐨?/span>base妯?/span>

鍨嬪拰鍦?/span>base妯″瀷鑷沖皯浣跨敤RLHF寰皟鐨?/span>Chat妯″瀷錛?/span>Chat妯″瀷鐨勮緇冧竴鑸兘鍖呮嫭濡備笅涓変釜姝ラ錛氶璁粌錛屾湁鐩戠潱寰?/span>

璋冨拰瀵歸綈銆?/span>

1. 鍦ㄩ璁粌闃舵錛屾ā鍨嬩細浠庡ぇ閲忔棤鏍囨敞鏂囨湰鏁版嵁闆嗕腑瀛︿範閫氱敤鐭ヨ瘑錛?/span>

2. 浣跨敤銆屾湁鐩戠潱寰皟銆嶏紙SFT錛変紭鍖栨ā鍨嬩互鏇村ソ鍦伴伒瀹堢壒瀹氭寚浠わ紱

3. 浣跨敤瀵歸綈鎶€鏈嬌LLM鍙互鏇存湁鐢ㄤ笖鏇村畨鍏ㄥ湴鍝嶅簲鐢ㄦ埛鎻愮ず銆?/span>

浜屻€侀璁粌錛?/strong>Pre-training錛夌瘒

2.1 鍏蜂綋浠嬬粛涓€涓?棰勮緇冿紙Pre-training錛夛紵

棰勮緇冿紙Pre-training錛夛細鍒╃敤鏁板崄浜垮埌鏁頒竾浜夸釜token鐨勫簽澶ф枃鏈鏂欏簱 瀵規(guī)ā鍨嬬戶緇?棰勮緇冿紝浣?妯″瀷 鑳藉 鏍規(guī)嵁

鎻愪緵鐨勬枃鏈潵棰勬祴銆屼笅涓€涓崟璇嶃€嶃€?/span>

涓夈€佹湁鐩戠潱寰皟錛?/strong>Supervised Tinetuning錛夌瘒

3.1 鍏蜂綋浠嬬粛涓€涓?鏈夌洃鐫e井璋冿紙Supervised Tinetuning錛夛紵

鏈夌洃鐫e井璋冿紙Supervised Tinetuning錛?/span>:铏界劧 SFT 璁粌鐩爣鍜?棰勮緇冿紙Pre-training錛夌被浼鹼紝涔熸槸 闇€瑕佹ā鍨?棰勬祴

銆屼笅涓€涓崟璇嶃€嶏紝浣嗘槸闇€瑕佷漢宸ユ爣娉ㄧ殑鎸囦護鏁版嵁闆嗭紝鍏朵腑妯″瀷鐨勮緭鍏ユ槸涓€涓寚浠わ紙鏍規(guī)嵁浠誨姟鐨勪笉鍚岋紝涔熷彲鑳藉寘鍚?/span>

涓€孌佃緭鍏ユ枃鏈級錛岃緭鍑轟負妯″瀷鐨勯鏈熷洖澶嶅唴瀹?/span>

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>