| 澶辨晥閾炬帴澶勭悊 |

|

Attention 鍗囩駭闈?PDF 涓嬭澆

杞澆鑷細(xì)http://www.python222.com/article/1164

鐩稿叧鎴浘錛?/strong>

涓昏鍐呭錛?/strong>

1 浼犵粺 Attention 瀛樺湪鍝簺闂錛?/strong>

1. 浼犵粺 Attention 瀛樺湪 涓婁笅鏂囬暱搴?綰︽潫闂錛?/span>

2. 浼犵粺 Attention 閫熷害鎱紝鍐呭瓨鍗犵敤澶э紱

2 Attention 浼樺寲鏂瑰悜

1. 鎻愬崌涓婁笅鏂囬暱搴?/span>

2. 鍔犻€熴€佸噺灝戝唴瀛樺崰鐢?/span>

3 Attention 鍙樹綋鏈夊摢浜涳紵

紼€鐤?/span> attention銆傚皢紼€鐤忓亸宸紩鍏?/span> attention 鏈哄埗鍙互闄嶄綆浜嗗鏉傛€э紱

• 綰挎€у寲 attention銆傝В寮€ attention 鐭╅樀涓庡唴鏍哥壒寰佸浘錛岀劧鍚庝互鐩稿弽鐨勯『搴忚綆?/span> attention 浠ュ疄鐜扮嚎鎬у鏉傚害錛?/span>

• 鍘熷瀷鍜屽唴瀛樺帇緙┿€傝繖綾繪柟娉曞噺灝戜簡鏌ヨ鎴栭敭鍊艱蹇嗗鐨勬暟閲忥紝浠ュ噺灝戞敞鎰忓姏鐭╅樀鐨勫ぇ灝忥紱

• 浣庨樁 self-Attention銆傝繖涓€緋誨垪宸ヤ綔鎹曡幏浜?/span> self-Attention 鐨勪綆闃跺睘鎬э紱

• Attention 涓庡厛楠屻€傝鐮旂┒鎺㈢儲浜嗙敤鍏堥獙 attention 鍒嗗竷鏉ヨˉ鍏呮垨鏇夸唬鏍囧噯 attention錛?/span>

• 鏀硅繘澶氬ご鏈哄埗銆傝緋誨垪鐮旂┒鎺㈢儲浜嗕笉鍚岀殑鏇夸唬澶氬ご鏈哄埗銆?/span>

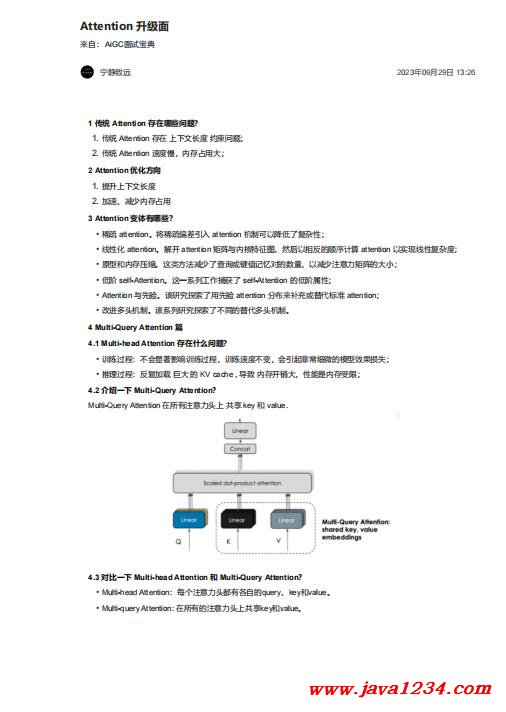

4 Multi-Query Attention 綃?/strong>

4.1 Multi-head Attention 瀛樺湪浠€涔堥棶棰橈紵

• 璁粌榪囩▼錛氫笉浼?xì)鏄捐憲濯勫搷璁l冭繃紼嬶紝璁粌閫熷害涓嶅彉錛屼細(xì)寮曡搗闈炲父緇嗗井鐨勬ā鍨嬫晥鏋滄崯澶憋紱

• 鎺ㄧ悊榪囩▼錛氬弽澶嶅姞杞?宸ㄥぇ 鐨?/span> KV cache , 瀵艱嚧 鍐呭瓨寮€閿€澶э紝鎬ц兘鏄唴瀛樺彈闄愶紱

4.2 浠嬬粛涓€涓?/strong> Multi-Query Attention錛?/strong>

Multi-Query Attention 鍦ㄦ墍鏈夋敞鎰忓姏澶翠笂 鍏變韓 key 鍜?/span> value.

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>