| 澶辨晥閾炬帴澶勭悊 |

|

澶фā鍨嬶紙LLMs錛夊弬鏁伴珮鏁堝井璋?PEFT) 闈?PDF 涓嬭澆

鐩稿叧鎴浘錛?/strong>

涓昏鍐呭錛?/strong>

1. 寰皟鏂規(guī)硶鏄暐錛熷浣曞井璋冿紵

fine-tune錛屼篃鍙叏鍙傚井璋冿紝bert寰皟妯″瀷涓€鐩寸敤鐨勮繖縐嶆柟娉曪紝鍏ㄩ儴鍙傛暟鏉冮噸鍙備笌鏇存柊浠ラ€傞厤棰嗗煙鏁版嵁錛屾晥鏋滃ソ銆?/span>

prompt-tune, 鍖呮嫭p-tuning銆?/span>lora銆?/span>prompt-tuning銆?/span>adaLoRA絳?/span>delta tuning鏂規(guī)硶錛岄儴鍒嗘ā鍨嬪弬鏁板弬涓庡井璋冿紝璁粌

蹇紝鏄懼瓨鍗犵敤灝戯紝鏁堟灉鍙兘璺?/span>FT錛?/span>fine-tune錛夋瘮浼氱◢鏈夋晥鏋滄崯澶憋紝浣嗕竴鑸晥鏋滆兘鎵撳鉤銆?/span>

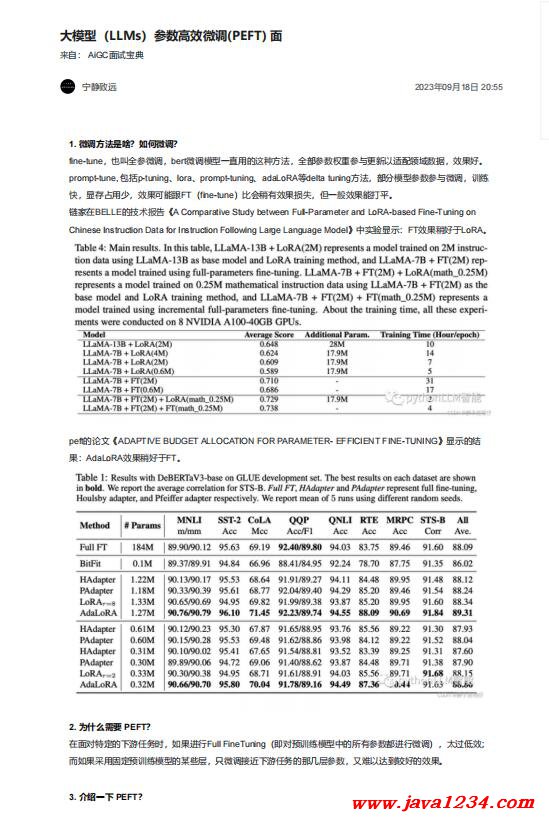

閾懼鍦?/span>BELLE鐨勬妧鏈姤鍛娿€?/span>A Comparative Study between Full-Parameter and LoRA-based Fine-Tuning on

Chinese Instruction Data for Instruction Following Large Language Model銆嬩腑瀹為獙鏄劇ず錛?/span>FT鏁堟灉紼嶅ソ浜?/span>LoRA銆?/span>

2. 涓轟粈涔堥渶瑕?/strong> PEFT錛?/strong>

鍦ㄩ潰瀵圭壒瀹氱殑涓嬫父浠誨姟鏃訛紝濡傛灉榪涜Full FineTuning錛堝嵆瀵歸璁粌妯″瀷涓殑鎵€鏈夊弬鏁伴兘榪涜寰皟錛夛紝澶繃浣庢晥錛?/span>

鑰屽鏋滈噰鐢ㄥ浐瀹氶璁粌妯″瀷鐨勬煇浜涘眰錛屽彧寰皟鎺ヨ繎涓嬫父浠誨姟鐨勯偅鍑犲眰鍙傛暟錛屽張闅句互杈懼埌杈冨ソ鐨勬晥鏋溿€?/span>

3. 浠嬬粛涓€涓?/strong> PEFT錛?/strong>

PEFT鎶€鏈棬鍦?/span>閫氳繃鏈€灝忓寲寰皟鍙傛暟鐨勬暟閲忓拰璁$畻澶嶆潅搴︼紝鏉ユ彁楂橀璁粌妯″瀷鍦ㄦ柊浠誨姟涓婄殑鎬ц兘錛屼粠鑰岀紦瑙eぇ鍨?/strong>

棰勮緇冩ā鍨嬬殑璁粌鎴愭湰銆傝繖鏍蜂竴鏉ワ紝鍗充嬌璁$畻璧勬簮鍙楅檺錛屼篃鍙互鍒╃敤棰勮緇冩ā鍨嬬殑鐭ヨ瘑鏉ヨ繀閫熼€傚簲鏂頒換鍔★紝瀹炵幇

楂樻晥鐨勮縼縐誨涔犮€?/span>

4. PEFT 鏈変粈涔堜紭鐐癸紵

PEFT鎶€鏈彲浠ュ湪鎻愰珮妯″瀷鏁堟灉鐨勫悓鏃訛紝澶уぇ緙╃煭妯″瀷璁粌鏃墮棿鍜岃綆楁垚鏈紝璁╂洿澶氫漢鑳藉鍙備笌鍒版繁搴﹀涔犵爺絀?/span>

涓潵銆傞櫎姝や箣澶栵紝FEFT鍙互緙撹В鍏ㄩ噺寰皟甯︽潵鐏鵑毦鎬ч仐蹇樼殑闂銆?/span>

|

鑻忓叕緗戝畨澶?32061202001004鍙?/p>

鑻忓叕緗戝畨澶?32061202001004鍙?/p>